https://youtu.be/91_hhex0CmU?si=-hKkZ4tT6RUf25TG

인공지능, 특히 딥러닝 모델에서의 양자화(quantization)는 딥러닝 모델을 더 빠르고 더 낮은 메모리 요구 사항으로 실행할 수 있는 저렴하고 쉬운 방법입니다. 딥러닝의 양자화는 정보 압축에 기초를 두고 있습니다. 딥러닝에서는 가중치(모델 파라미터) 및/또는 활성화(activation)의 수치적 정밀도를 줄이는 것을 의미합니다. 모델을 양자화하면 메모리가 작아지고, 소비전력이 줄어듭니다.본 웨비나에서는 딥 러닝에서 양자화의 기초원리에 대해 설명하고, 최신 기술동향 및 여기서 언급된 기술들이 실제로 어떻게 실행되는 지 실제 코딩 데모 실현을 보여줄 계획입니다.

DNN에서 보면 training과 inference가 있다. 초창기에는 training에 focus을 맞추고 있다가 최근부터 inference로 focus가 옮겨지고 있다. 실제로 적용이 되는 부분에 edge device에서의 computing에 초점이 옮겨져서 진행되고 있다. 최근에는 많은 연구들이 이 쪽에서 진행이 되고 있다. 현재 강의를 하고 있는 정태희 박사가 이 분야를 연구하고 있다.

기존의 trained 된 neural network model이 있을 때, 이 기존의 trained된 모델이 있을 때 새로운 input이 있고 output이 있을 때 이걸 어떻게 optimize시켜서 improve을 시킬 것이냐. 이 쪽에 많은 연구들이 일어나고 있다.

compression은 모델을 pruning 시키는 것. 그리고 quantization, compilation 이렇게 3가지 분야가 있다. 이렇게 3가지 분야에서 연구들이 진행되고 있다. compression은 지난번 웨비나에서 수업을 하셨음. 참고하면 좋을 것.

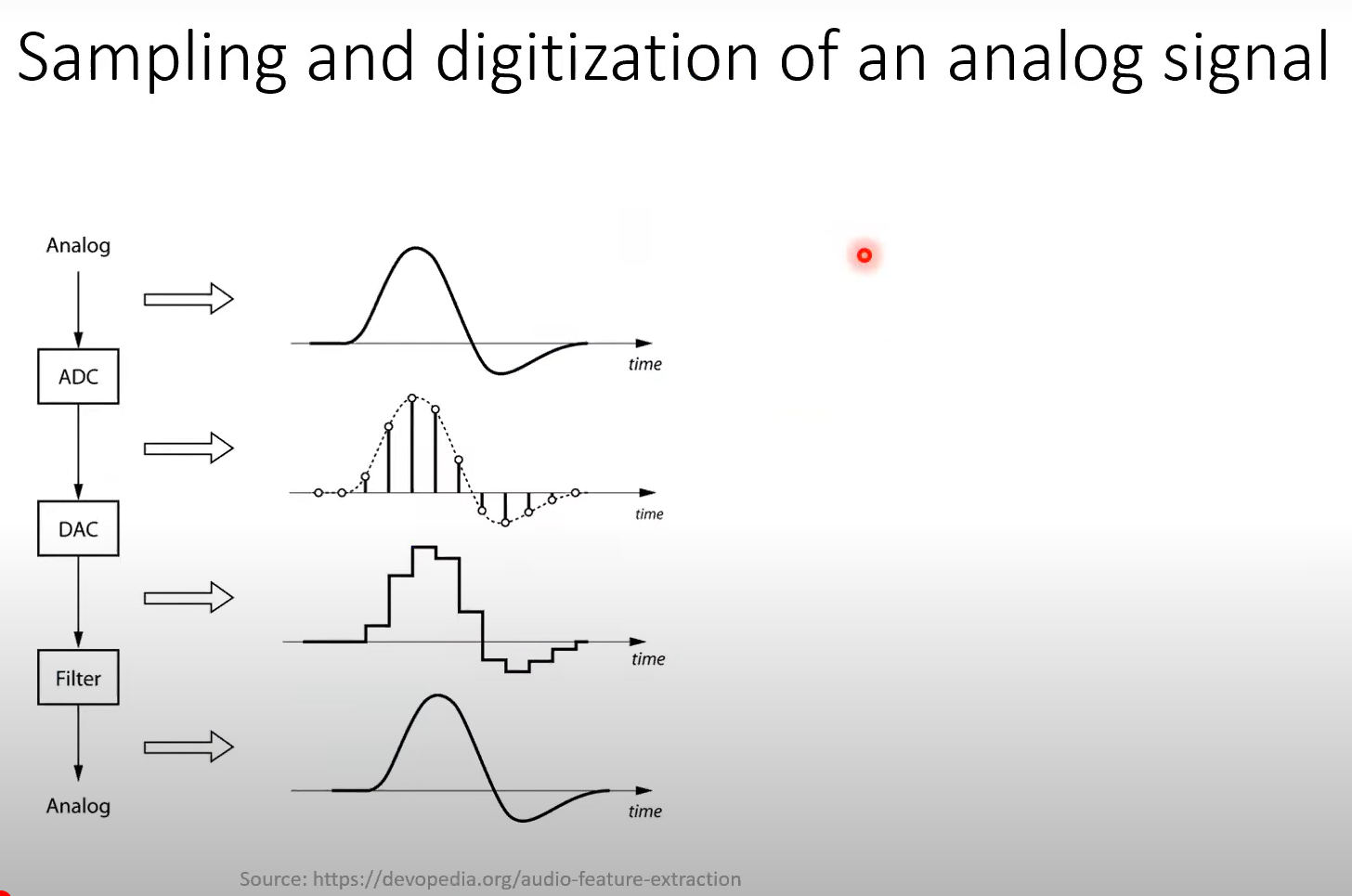

이게 quatization과 비슷한 컨셉일 것. x축이 time이고 y축이 intensity.

이런 signal이 있을 때 특정 time 간격을 가지고 sampling하는 것 이를 digitalization이라고 한다. 이것과 양자화가 비슷한 컨셉이다.

특정 value가 있으면 컴퓨터에서 주로 표현되는 것은 fp32이다. 이것을 어떤 특정 digit으로 0.156으로 나타내고, 이를 fixed point라고 말한다. 이를 다시 integar으로 나타낸다. 156 * 10^-3으로 표현할 수 있다. fp값을 fixed number나 정수로 나타낼 수 있다. 이런 식으로 나타내는 것을 양자화라고 한다.

floating point value를 quantization value로 mapping하는 것. 일반적으로 DNN에서 quantization이라고 하면 8bit을 사용함. 0에서 255 사이의 값을 가진다. 이런 식으로 mapping하는 것.

'대학원 > LLM quantization study' 카테고리의 다른 글

| attention mechanism에 대해 다시 공부해보자. (0) | 2024.12.30 |

|---|---|

| [이 부분도 공부해보면 좋겠다] [fastcampus] 오픈소스 LLM을 활용한 고급 Fine-tuning & AI 서비스 구현 (0) | 2024.12.30 |

| 워드 임베딩부터 다시 공부해보자. (0) | 2024.12.30 |

| [STICK 2023] Model Quantization 강의 공부 (1) | 2024.12.29 |